Cómo supervisar la aplicación LangFlow

En nuestro artículo Langflow, creador de aplicaciones de IA de bajo código, exploramos cómo empezar a utilizar el entorno de programación visual de este creador de aplicaciones de IA de bajo código. Permite a cualquier persona, incluso sin conocimientos de programación, crear aplicaciones basadas en grandes modelos de redes neuronales. Podrían ser chatbots de IA o aplicaciones de procesamiento de documentos que pueden analizar y resumir contenido.

Langflow utiliza un enfoque de bloques de construcción en el que los usuarios conectan componentes prefabricados para crear la aplicación deseada. Sin embargo, a menudo surgen dos retos clave: la resolución de problemas cuando las redes neuronales se comportan de forma inesperada y la gestión de los costes. Las redes neuronales requieren importantes recursos informáticos, por lo que es esencial controlar y predecir los gastos de infraestructura.

LangWatch aborda ambos retos. Esta herramienta especializada ayuda a los desarrolladores de Langflow a supervisar las solicitudes de los usuarios, realizar un seguimiento de los costes y detectar anomalías, como cuando las aplicaciones se utilizan de forma no deseada.

Esta herramienta se diseñó originalmente como un servicio, pero puede desplegarse en cualquier servidor, incluso localmente. Se integra con la mayoría de los proveedores de LLM, ya sean basados en la nube o locales. Al ser de código abierto, LangWatch puede adaptarse a casi cualquier proyecto: añadiendo nuevas funciones o conectándose con sistemas internos.

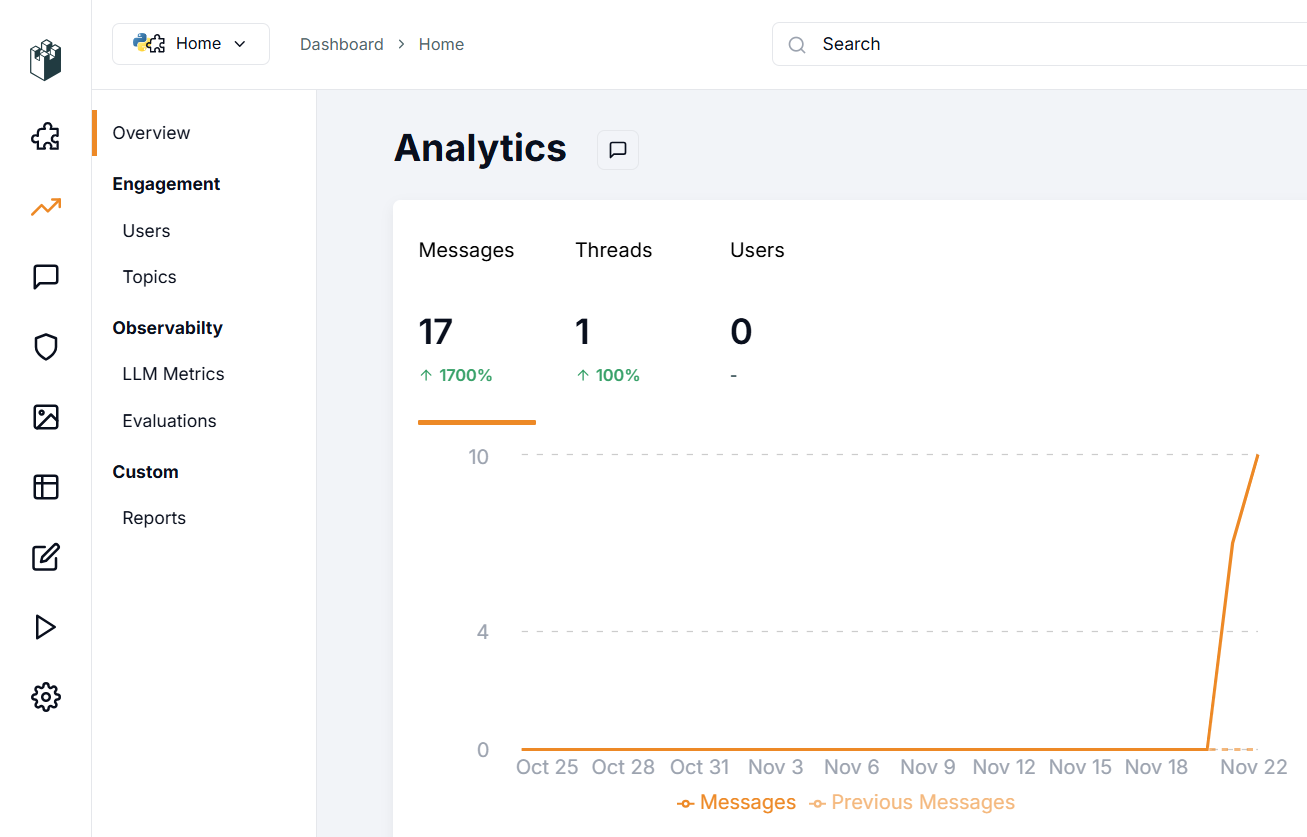

LangWatch permite configurar alertas cuando determinadas métricas superan los umbrales definidos. Esto le ayuda a detectar rápidamente aumentos inesperados en los costes de las solicitudes o retrasos inusuales en las respuestas. La detección precoz ayuda a evitar gastos imprevistos y posibles ataques al servicio.

Para los investigadores de redes neuronales, esta aplicación permite tanto la supervisión como la optimización de las peticiones habituales de los usuarios. También proporciona herramientas para evaluar la calidad de respuesta del modelo y realizar ajustes cuando sea necesario.

Inicio rápido

Preparación del sistema

Al igual que Langflow, la forma más sencilla de ejecutar la aplicación es a través de un contenedor Docker. Antes de instalar LangWatch, necesitarás instalar Docker Engine en tu servidor. En primer lugar, actualiza tu caché de paquetes y los paquetes a sus últimas versiones:

sudo apt update && sudo apt -y upgradeInstala los paquetes adicionales requeridos por Docker:

sudo apt -y install apt-transport-https ca-certificates curl software-properties-commonDescarga la clave GPG para añadir el repositorio oficial de Docker:

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpgAñade el repositorio a APT utilizando la clave que descargaste e instalaste anteriormente:

echo "deb [arch=$(dpkg --print-architecture) signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/nullActualice la lista de paquetes:

sudo apt updatePara asegurarte de que Docker se instalará desde el repositorio recién añadido y no desde el del sistema, puedes ejecutar el siguiente comando:

apt-cache policy docker-ceInstalar motor Docker:

sudo apt install docker-ceCompruebe que Docker se ha instalado correctamente y que el demonio correspondiente se está ejecutando y se encuentra en el estado active (running):

sudo systemctl status docker● docker.service - Docker Application Container Engine

Loaded: loaded (/lib/systemd/system/docker.service; enabled; vendor preset>

Active: active (running) since Mon 2024-11-18 08:26:35 UTC; 3h 27min ago

TriggeredBy: ● docker.socket

Docs: https://docs.docker.com

Main PID: 1842 (dockerd)

Tasks: 29

Memory: 1.8G

CPU: 3min 15.715s

CGroup: /system.slice/docker.service

Construir y ejecutar

Con el motor Docker instalado y en ejecución, puede descargar el repositorio de la aplicación LangWatch:

git clone https://github.com/langwatch/langwatchLa aplicación incluye un archivo de configuración de ejemplo con variables de entorno. Copie este archivo para que la utilidad de creación de imágenes pueda procesarlo:

cp langwatch/.env.example langwatch/.envAhora estás listo para el primer lanzamiento:

sudo docker compose up --buildEl sistema tardará un momento en descargar todas las capas contenedoras necesarias para LangWatch. Una vez completado, verás un mensaje de consola indicando que la aplicación está disponible en:

http://[LeaderGPU_IP_address]:3000

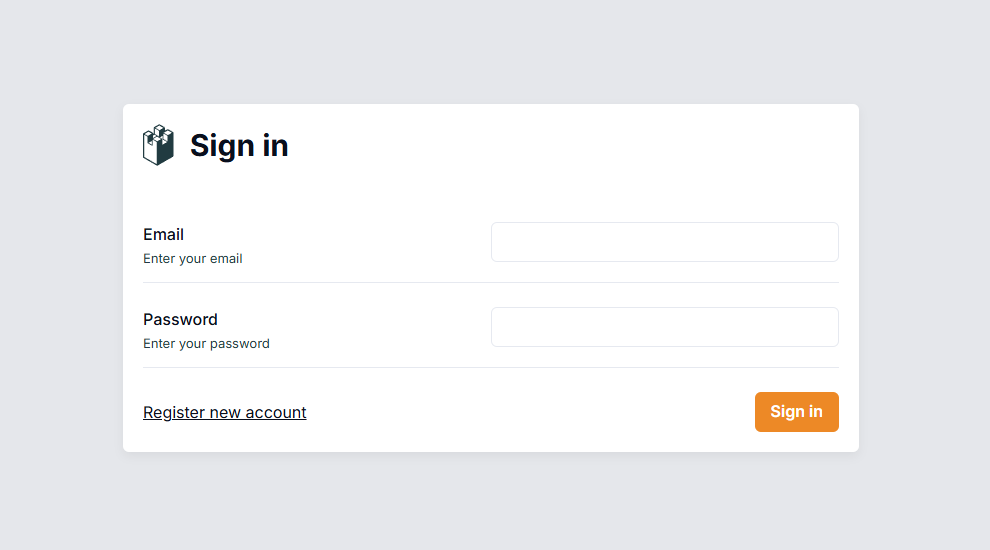

Vaya a esta página en su navegador, donde se le pedirá que cree una cuenta de usuario:

A diferencia de Langflow, este sistema tiene la autenticación activada por defecto. Después de iniciar sesión, tendrá que configurar el sistema para recopilar datos de su servidor Langflow.

Integración con Langflow

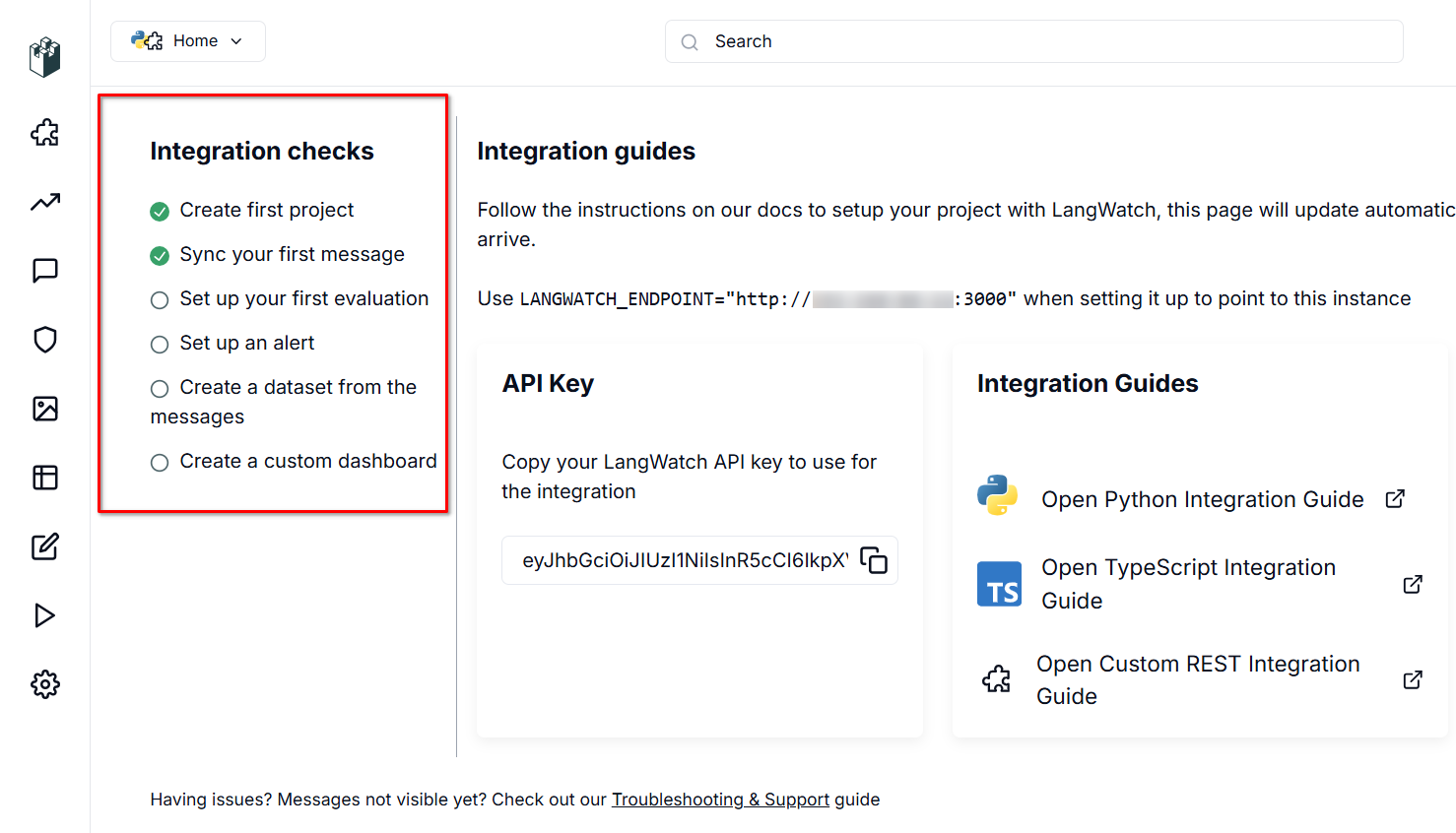

LangWatch necesita una fuente de datos para funcionar. El servidor escucha en el puerto 3000 y utiliza una API RESTful, que autentica los datos entrantes a través de una clave de API generada automáticamente.

Para habilitar la transferencia de datos, tendrá que establecer dos variables en los archivos de configuración de Langflow: LANGWATCH_ENDPOINT y LANGWATCH_API_KEY. En primer lugar, establezca una conexión SSH a su servidor Langflow (que debe estar fuera de línea durante este proceso).

Navegue hasta el directorio con la configuración de ejemplo para Docker:

cd langflow/docker_exampleAbra el archivo de configuración para editarlo:

nano docker-compose.ymlEn la sección "Entorno:", añada las siguientes variables (sin corchetes [] ni comillas):

- LANGWATCH_API_KEY= [YOUR_API_KEY]

- LANGWATCH_ENDPOINT=http://[IP_ADDRESS]:3000El archivo YML requiere un formato específico. Siga estas dos reglas clave:

- Utilice espacios (2 ó 4) para la sangría, nunca tabuladores.

- Mantenga una estructura jerárquica adecuada con una sangría coherente.

Guarde el archivo con Ctrl + O y salga del editor con Ctrl + X, Langflow ya está listo para ejecutarse:

sudo docker compose upDespués del lanzamiento, verifique que todo funciona correctamente. Cree un nuevo proyecto o abra uno existente, luego inicie un diálogo a través de Playground. Langflow enviará automáticamente datos a LangWatch para su monitorización, que podrá ver en la interfaz web.

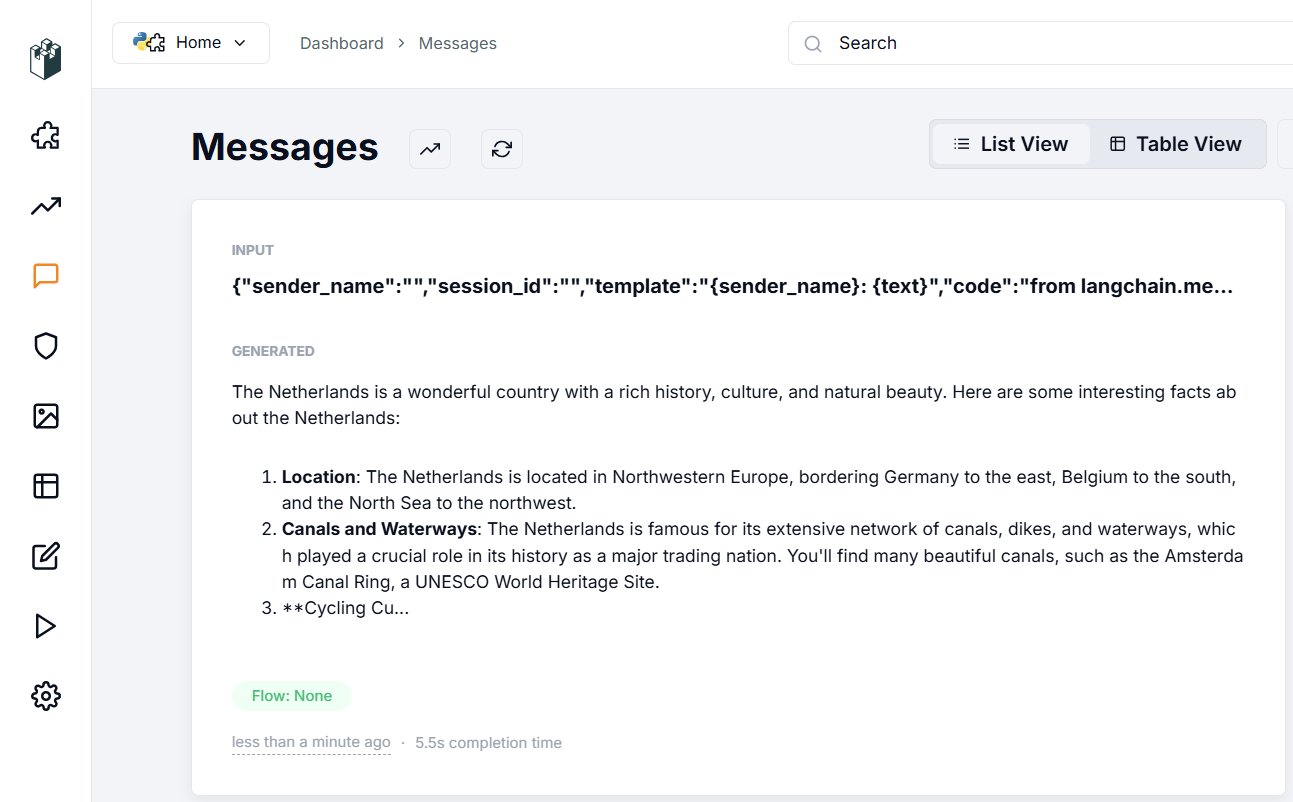

En la sección de verificación de la integración, aparece una marca de verificación en el elemento "Sincronizar el primer mensaje". Esto indica que los datos de Langflow están fluyendo con éxito a LangWatch, confirmando que su configuración es correcta. Examinemos que aparece en la sección Messages:

La sección Mensajes muestra los datos introducidos en la aplicación, los parámetros utilizados para la generación de la respuesta y la propia respuesta de la red neuronal. Puede evaluar la calidad de la respuesta y utilizar varios filtros para ordenar los datos, incluso con cientos o miles de mensajes.

Tras esta configuración inicial, explora sistemáticamente las funciones de la aplicación. En la sección Evaluations, puedes configurar algoritmos de verificación de diálogos para la moderación de diálogos o el reconocimiento de datos, como PII Detection. Esta función escanea las entradas en busca de información sensible, como números de la seguridad social o números de teléfono.

La aplicación ofrece opciones tanto locales como basadas en la nube a través de proveedores como Azure o Cloudflare. Para utilizar las funciones en la nube, necesitarás cuentas en estos servicios, junto con sus direcciones de punto final y claves API. Ten en cuenta que se trata de proveedores externos, así que comprueba directamente los costes de sus servicios.

Para las opciones locales, la aplicación cuenta con sofisticadas funciones RAG (Retrieval-augmented generation). Puede medir la precisión y relevancia de los contenidos generados por RAG y utilizar las estadísticas recopiladas para optimizar el sistema RAG y obtener respuestas más precisas de la red neuronal.

Ver también:

Actualizado: 04.01.2026

Publicado: 22.01.2025