Ventajas y desventajas de compartir la GPU

La Ley de Moore sigue vigente desde hace casi medio siglo. Los chips procesadores siguen incorporando más transistores y las tecnologías avanzan día a día. A medida que evoluciona la tecnología, también lo hace nuestro enfoque de la informática. El auge de determinadas tareas informáticas ha influido significativamente en el desarrollo del hardware. Por ejemplo, los dispositivos diseñados originalmente para el procesamiento de gráficos son ahora herramientas clave y asequibles para las redes neuronales modernas.

La gestión de los recursos informáticos también se ha transformado. Ahora, los servicios masivos rara vez utilizan mainframes, como hacían en los años setenta y ochenta. En su lugar, prefieren los servicios en la nube o construir su propia infraestructura. Este cambio ha modificado las demandas de los clientes, que se centran en un escalado rápido y a la carta y en maximizar el uso de los recursos informáticos asignados.

Las tecnologías de virtualización y contenedorización surgieron como soluciones. Las aplicaciones se empaquetan ahora en contenedores con todas las bibliotecas necesarias, lo que simplifica la implantación y el escalado. Sin embargo, la gestión manual se volvió impracticable a medida que el número de contenedores se disparaba a miles. Orquestadores especializados como Kubernetes se encargan ahora de la gestión y el escalado eficaces. Estas herramientas se han convertido en una parte esencial de cualquier infraestructura de TI moderna.

Virtualización de servidores

Al mismo tiempo, las tecnologías de virtualización evolucionaron, permitiendo la creación de entornos aislados dentro de un único servidor físico. Las máquinas virtuales se comportan de forma idéntica a los servidores físicos normales, lo que permite utilizar herramientas de gestión estándar. Dependiendo del hipervisor, a menudo se incluye una API especializada que facilita la automatización de procedimientos rutinarios.

Sin embargo, esta flexibilidad viene acompañada de una menor seguridad. Los atacantes han pasado de centrarse en las máquinas virtuales individuales a explotar las vulnerabilidades del hipervisor. Al hacerse con el control de un hipervisor, los atacantes pueden acceder a voluntad a todas las máquinas virtuales asociadas. A pesar de las continuas mejoras de seguridad, los hipervisores modernos siguen siendo objetivos atractivos.

La virtualización tradicional aborda dos cuestiones clave. Primera cuestión: garantiza el aislamiento de las máquinas virtuales entre sí. Las soluciones bare-metal evitan este problema, ya que los clientes alquilan servidores físicos enteros bajo su control. Pero en el caso de las máquinas virtuales, el aislamiento se basa en el software a nivel del hipervisor. Un error de código o un fallo aleatorio pueden comprometer este aislamiento, con el consiguiente riesgo de fuga o corrupción de datos.

El segundo problema se refiere a la gestión de recursos. Aunque es posible garantizar la asignación de recursos a máquinas virtuales específicas, la gestión de numerosas máquinas plantea un dilema. Los recursos pueden infrautilizarse, lo que se traduce en un menor número de máquinas virtuales por servidor físico. Este escenario no es rentable para la infraestructura y conduce inevitablemente a un aumento de los precios.

Otra alternativa es utilizar mecanismos automáticos de gestión de recursos. Aunque a una máquina virtual se le asignan características específicas declaradas, en realidad sólo se le proporciona el mínimo necesario dentro de estos límites. Si la máquina necesita más tiempo de procesador o RAM, el hipervisor intentará proporcionárselo, pero no puede garantizarlo. Esta situación es similar al overbooking de los aviones, cuando las aerolíneas venden más billetes de los asientos disponibles.

La lógica es idéntica. Si las estadísticas muestran que un 10% de los pasajeros no llegan a tiempo a su vuelo, las aerolíneas pueden vender un 10% más de billetes con un riesgo mínimo. Si llegan todos los pasajeros, algunos no cabrán a bordo. La aerolínea se enfrentará a consecuencias menores en forma de indemnización, pero probablemente seguirá con esta práctica.

Muchos proveedores de infraestructuras emplean una estrategia similar. Algunos son transparentes al respecto, declarando que no garantizan la disponibilidad constante de recursos informáticos pero ofrecen precios significativamente reducidos. Otros utilizan mecanismos similares sin anunciarlo. Apuestan a que no todos los clientes utilizarán sistemáticamente el 100% de los recursos de sus servidores y, aunque algunos lo hagan, serán minoría. Mientras tanto, los recursos ociosos generan beneficios.

En este contexto, las soluciones bare-metal tienen una ventaja. Garantizan que los recursos asignados son totalmente gestionados por el cliente y no compartidos con otros usuarios del proveedor de infraestructura. Esto elimina los escenarios en los que la alta carga de un usuario de un servidor vecino repercute negativamente en el rendimiento.

Virtualización de GPU

La virtualización clásica se enfrenta inevitablemente al reto de emular dispositivos físicos. Para reducir los gastos generales, se han desarrollado tecnologías especiales que permiten a las máquinas virtuales acceder directamente a los dispositivos físicos del servidor. Este enfoque funciona bien en muchos casos, pero cuando se aplica a los procesadores gráficos, crea limitaciones inmediatas. Por ejemplo, si un servidor tiene instaladas 8 GPU, sólo 8 máquinas virtuales pueden acceder a ellas.

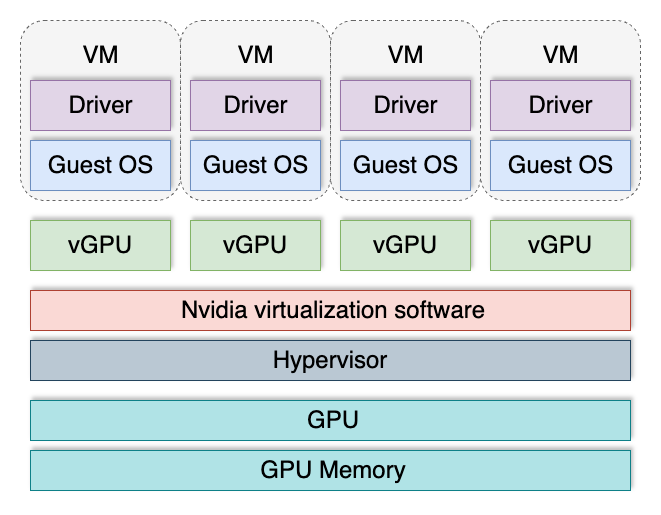

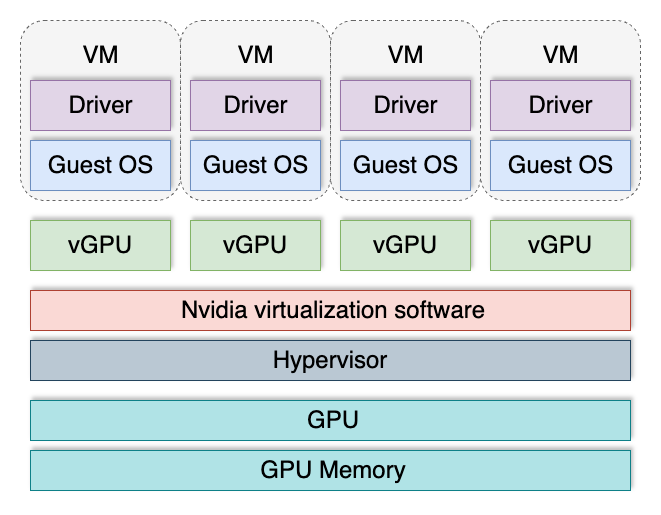

Para superar esta limitación, se inventó la tecnología vGPU. Divide una GPU en varias lógicas, que pueden asignarse a máquinas virtuales. Esto permite que cada máquina virtual tenga su "trozo de tarta", y su número total ya no está limitado por el número de tarjetas de vídeo instaladas en el servidor.

Las GPU virtuales se utilizan con mayor frecuencia cuando se construye VDI (Virtual Desktop Infrastructure) en áreas en las que las máquinas virtuales requieren aceleración 3D. Por ejemplo, un puesto de trabajo virtual para un diseñador o planificador suele implicar procesamiento gráfico. La mayoría de las aplicaciones de estos campos realizan cálculos tanto en el procesador central como en la GPU. Este enfoque híbrido aumenta significativamente la productividad y garantiza un uso óptimo de los recursos de cálculo disponibles.

Sin embargo, esta tecnología presenta varios inconvenientes. No es compatible con todas las GPU y sólo está disponible en el segmento de servidores. La compatibilidad también depende de la versión instalada del sistema operativo y del controlador de la GPU. vGPU tiene un mecanismo de licencia independiente, lo que incrementa sustancialmente los costes de las operaciones. Además, sus componentes de software pueden servir potencialmente como vectores de ataque.

Recientemente, se ha publicado información sobre ocho vulnerabilidades que afectan a todos los usuarios de GPU NVIDIA®. Se identificaron seis vulnerabilidades en los controladores de la GPU y dos en el software vGPU. Estos problemas se solucionaron rápidamente, pero sirven para recordar que los mecanismos de aislamiento de estos sistemas no son impecables. La supervisión constante y la instalación oportuna de actualizaciones siguen siendo las principales formas de garantizar la seguridad.

Cuando se construye una infraestructura para procesar datos confidenciales y sensibles de los usuarios, cualquier virtualización se convierte en un factor de riesgo potencial. En tales casos, un enfoque bare-metal puede ofrecer mejor calidad y seguridad.

Conclusión

Construir una infraestructura informática siempre requiere una evaluación de riesgos. Entre las preguntas clave que hay que plantearse se incluyen: ¿Están protegidos de forma segura los datos de los clientes? ¿Crean las tecnologías elegidas vectores de ataque adicionales? ¿Cómo se pueden aislar y eliminar las posibles vulnerabilidades? Responder a estas preguntas ayuda a tomar decisiones informadas y a protegerse contra problemas futuros.

En LeaderGPU, hemos llegado a una conclusión clara: actualmente, la tecnología bare-metal es superior a la hora de garantizar la seguridad de los datos de los usuarios y, al mismo tiempo, constituye una base excelente para crear una nube bare-metal. Este enfoque permite a nuestros clientes mantener la flexibilidad sin asumir los riesgos añadidos asociados a la virtualización de la GPU.

Ver también:

Actualizado: 04.01.2026

Publicado: 23.01.2025